AI推論サーバーの定義と市場概況

AI推論サーバーはユーザーに強力なリアルタイム推論能力を提供し、センターサイドのAI推論シナリオに広く応用され、ユーザーの重い計算負荷への対応を支援します。卓越した計算性能、高い環境適応性、低消費電力、容易な導入・保守、クラウドとエッジの連携サポートなどの特徴を備え、人工知能、スマート製造、インテリジェントエッジなどのアプリケーションシナリオにおける演算能力のニーズを満たします。

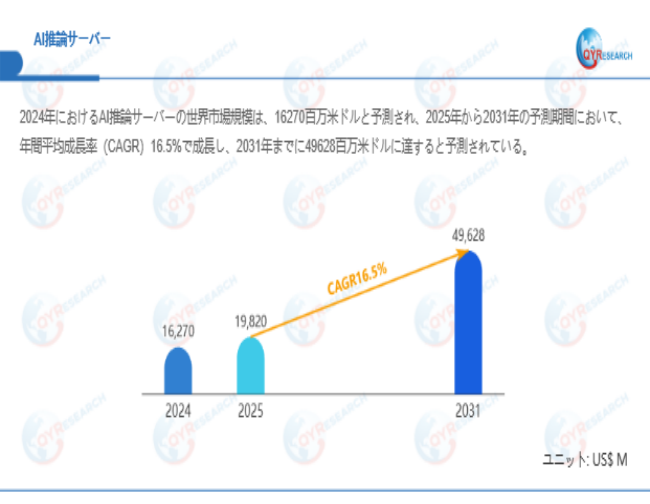

QYResearchが最新発表した「AI推論サーバー―グローバル市場シェアとランキング、全体の売上と需要予測、2026~2032」市場調査報告書によると、世界AI推論サーバー市場規模は2024年の約16270百万米ドルから2025年には19820百万米ドルへ着実に成長し、予測期間中に16.5%の複合年間成長率(CAGR)で拡大を続け、2031年には49628百万米ドルに達する見込みである。

AI推論サーバー市場規模(百万米ドル)、2024-2031年

上記データは、QYResearch報告書「AI推論サーバー―グローバル市場シェアとランキング、全体の売上と需要予測、2025~2031」に基づく

主な推進要因:

1. 大規模AI活用の本格展開による直接的な需要拡大:日本企業が生成AIを技術検証段階から大規模な業務適用段階へと移行させる中で、AI推論サーバー製品の位置づけは「選択肢」から「必須インフラ」へと変化している。顧客対応、コンテンツ生成、インテリジェントな意思決定などの分野において、推論処理は中核的な業務プロセスとなっており、高並列・低遅延を実現できるAI推論サーバーの導入が企業調達を直接的に後押ししている。

2. クラウド・エッジ協調アーキテクチャ進化に伴う算力の分散配置需要:高いリアルタイム性やネットワーク帯域制約を伴う用途に対応するため、日本市場では集中型クラウド推論から分散型エッジ推論への移行が進んでいる。このアーキテクチャ変革により、工場、店舗、医療機関などの現場環境に適応可能な、コンパクトかつ高環境耐性を備えたAI推論サーバーが求められている。

3. 総所有コスト(TCO)および投資対効果(ROI)に対する精緻な評価志向:クラウドAPI利用による継続的かつ不確実な運用コストと比較し、日本企業は、私有環境にAI推論サーバーを段階的に導入することで、長期的かつ管理可能な算力資産を保有することを志向している。その結果、高い性能電力比と長期運用の容易性を備えたAI推論サーバー製品が、コスト管理の観点から明確な優位性を示している。

4. チップおよびハードウェア技術の継続的進化による性能飛躍:次世代CPU(例:インテル® Xeon® 6 プロセッサー)は、AMXなどの強化されたAIアクセラレーション機能を統合しており、GPUやAIアクセラレータも推論効率を大幅に向上させている。これにより、単一のAI推論サーバー当たりの算力密度と処理スループットが飛躍的に向上し、より少ない物理サーバーで同等以上の業務要件を満たすことが可能となり、ハードウェア更新サイクルを加速させている。

5. 推論ワークロードの高度化・多様化トレンド:AIモデルの適用範囲は、単純なテキスト生成からマルチモーダル理解、AIエージェントによる対話、複雑な業務プロセス自動化へと拡大している。これにより、AI推論サーバーには高スループットのバッチ推論と低遅延のリアルタイム推論を同時に処理できる、計算性能、メモリ帯域、I/O性能の総合的な強化が求められている。

機会:

1. 業界別垂直領域における高度なカスタマイズ機会:AI活用が業界の中核業務へと浸透するにつれ、汎用的な推論ソリューションでは要件を満たしきれなくなっている。AI行政におけるインテリジェント審査、AI金融におけるリアルタイムリスク管理、AI医療における画像解析などに向けて、ハードウェア選定からモデル最適化、アプリケーション事前実装までを含む業界特化型AI推論サーバーや統合アプライアンスは、高付加価値な成長分野となる。

2. 国産化および多様な算力エコシステム構築の好機:グローバルサプライチェーン再編と技術的自立性の追求を背景に、日本市場ではARMやRISC-Vなど多様なアーキテクチャ、ならびに国産・オープンソース大規模モデルと高い親和性を持つAI推論サーバーへの潜在的需要が存在する。オープン性、互換性、安全性を兼ね備えた代替ソリューションを提供できるベンダーにとって、戦略的機会が広がっている。

3. ソフトウェアとハードウェアを統合した「即時利用」体験の競争優位性:企業ユーザーは、導入から本番稼働までの時間短縮を重視している。OS、推論フレームワーク、主要モデル、最適化済みパラメータを統合し、「開梱即使用」や「ワンクリック展開」を実現するAI推論サーバー製品は、導入障壁を大幅に下げ、市場競争において優位性を確立できる。

4. AIエージェント普及に伴う次世代インタラクション基盤需要:AIエージェントは、従来型チャットボットと比較して約25倍の推論負荷およびネットワーク通信を発生させるとされている。これにより、高並列、長文脈処理、低遅延の連続推論を支える専用サーバークラスタへの需要が生まれ、高性能AI推論サーバー市場拡大の新たな成長エンジンとなる。

5. グリーンデータセンターおよび持続可能性政策による更新需要:日本ではデータセンターのエネルギー効率に対する規制が厳格化している。全液冷などの先進冷却技術を採用し、PUE値1.15未満を実現するグリーンAI推論サーバーは、運用コスト削減だけでなく、環境規制対応の観点からも、データセンター新設・更新時の優先選択肢となっている。

制約する要因:

1. 高額な初期投資と不透明な投資回収モデル:高性能AI推論サーバーの導入には、ハードウェア調達、施設改修、運用体制構築など多額の初期投資が必要である。一方で、AI導入による具体的な財務効果を定量化することは依然として難しく、投資対効果の不確実性が購買意思決定を大きく抑制している。

2. 技術選定の複雑化とサプライチェーン変動リスク:急速に進化するCPU/GPU、各種AIアクセラレータ、推論フレームワークの中から最適構成を選定することは顧客にとって大きな負担である。加えて、グローバルな半導体供給の変動は、主要部品の供給不安定化やコスト上昇を招き、AI推論サーバー製品の納期・価格に影響を及ぼす。

3. 高度な運用人材の深刻な不足とスキルミスマッチ:AI推論サーバーの最適運用には、GPUトポロジ設計、NUMA設定、RDMAネットワーク最適化など高度な専門知識が不可欠である。しかし、ハードウェアとAIモデル双方に精通した上級運用エンジニアは著しく不足しており、性能未発揮や設定不備による障害リスクが普遍的課題となっている。

4. モデル・ハードウェア高速進化による資産価値下落への懸念:AIモデルと計算基盤は極めて速い速度で進化しており、企業は高額投資したAI推論サーバーが短期間で陳腐化することを懸念している。この技術ライフサイクルの不確実性が、購入よりもリースやクラウド利用といった柔軟な消費モデルを選好させる要因となっている。

5. データおよびモデル保護における全方位的セキュリティ課題:AI推論サーバーのオンプレミス導入はデータ転送リスクを低減する一方で、サーバー内部におけるモデル資産の逆解析や推論データ漏洩といった新たな脅威も存在する。ハードウェアレベルの暗号化技術は進展しているものの、ハードウェアからファームウェア、アプリケーション層までを網羅する完全な信頼基盤の構築は、依然として業界共通の課題である。

この記事は、QYResearch が発行したレポート「AI推論サーバー―グローバル市場シェアとランキング、全体の売上と需要予測、2026~2032」

■レポートの詳細内容・お申込みはこちら

https://www.qyresearch.co.jp/reports/1624556/ai-inference-server

QYResearchについて

QYResearch(QYリサーチ)は、高品質の市場調査レポートとコンサルティングサービスをお客様に提供する、市場調査とコンサルティングの専門会社です。QYResearchは2007年に米国カリフォルニア州に設立され、米国、日本、韓国、中国、ドイツ、インド、スイスなど世界中に複数の支社を展開しています。QYResearchには18年以上の経験を持ち、経験豊富で優秀な専門家チームがおり、お客様にあらゆるレベルの市場調査とコンサルティングサービスを提供しています。

QYResearchのサービスは、エネルギー、化学・材料、エレクトロニクス、ヘルスケア、食品・飲料、自動車、機械・設備など、幅広い産業分野をカバーしています。業界の深い洞察力と豊富な市場経験を生かし、お客様が市場ダイナミクスを理解し、開発トレンドを把握し、効果的な市場戦略を策定できるよう、カスタマイズされた市場調査レポートとソリューションを提供しています。

■お問い合わせ先

世界トップレベルの調査会社QYResearch(QYリサーチ)

URL:https://www.qyresearch.co.jp

日本の住所:〒104–0061東京都中央区銀座 6–13–16 銀座 Wall ビル UCF5階

TEL:050–5893–6232(日本);0081–5058936232(グローバル)

マーケティング担当 japan@qyresearch.com